SEO için Robots.txt En Kapsamlı Kılavuz

BulutPress® içerik yönetim sistemi ile hazırlanan web sitelerinde, robots.txt dosyası, içine xml site haritası direktifi de eklenmiş olarak, otomatik olarak yaratılır ve sistem tarafından güncellenerek ihtiyaçlarınıza uygun şekilde çalışması sağlanır. Robots.txt için en kapsamlı kılavuzu sizler için oluşturduk.

Robots.txt Dosyası Nedir ve Ne İşe Yarar?

Bir robots.txt dosyası, arama motorlarına web sitenizin etkileşim kurallarının ne olduğunu söyler. SEO yapmanın büyük bir kısmı, arama motorlarına doğru sinyalleri göndermekle ilgilidir ve robots.txt, tarama tercihlerinizi arama motorlarına iletmenin yollarından biridir.

2019'da robots.txt standardıyla ilgili bazı gelişmeler gördük: Google, Robots Hariç Tutma Protokolü için bir uzantı önerdi ve robots.txt ayrıştırıcısını açık kaynaklı hale getirdi.

- Google'ın robots.txt yorumlayıcısı oldukça esnektir ve şaşırtıcı derecede bağışlayıcıdır.

- Yönergelerin karıştırılması durumunda, Google güvenli tarafta yer alır ve bölümlerin kısıtlanmaması yerine sınırlandırılması gerektiğini varsayar.

- robots.txt dosyası, arama motorlarına hangi URL'lere erişilmeyeceğini söyler.

- Arama motorları, web sitesini taramak için herhangi bir talimat olup olmadığını görmek için bir web sitesinin robots.txt dosyasını düzenli olarak kontrol eder. Bu talimatlara, direktif komutları adını veriyoruz.

Robots.txt dosyası yoksa veya geçerli yönergeler yoksa, arama motorları tüm web tasarımda bulabildiği tüm sayfaları tarar.

Tüm büyük arama motorları robots.txt dosyasına saygı gösterse de, arama motorları robots.txt dosyanızı (parçalarını) yok saymayı seçebilir. robots.txt dosyasındaki yönergeler arama motorları için güçlü bir sinyal olsa da, robots.txt dosyasının bir zorunluluktan ziyade arama motorlarına yönelik bir dizi isteğe bağlı yönerge olduğunu hatırlamak önemlidir.

Robots.txt, SEO evrenindeki en hassas dosyadır. Tek bir karakter bütün bir siteyi bozabilir.

Kevin Indig, SEO Direktörü, Shopify

Robots.txt Dosyası Terminolojisi: Robots.txt dosyası, robot dışlama standardının uygulanmasıdır veya robot dışlama protokolü olarak da adlandırılır.

Neden Robots.txt İle İlgilenmelisiniz?

Robots.txt, SEO açısından önemli bir rol oynar. Arama motorlarına web sitenizi en iyi nasıl tarayabileceklerini söyler. Robots.txt dosyasını kullanarak arama motorlarının web sitenizin belirli bölümlerine erişmesini engelleyebilir, yinelenen içeriği önleyebilir ve arama motorlarına web sitenizi nasıl daha verimli bir şekilde tarayabilecekleri konusunda yardımcı ipuçları verebilirsiniz. Yine de robots.txt dosyanızda değişiklik yaparken dikkatli olun: Bu dosya, web sitenizin büyük bölümlerini arama motorları için erişilemez hale getirme potansiyeline sahiptir.

Robots.txt, kopya içeriği azaltmak için genellikle gereğinden fazla kullanılır, dahili bağlantıları öldürür, bu nedenle ona gerçekten dikkat etmeniz gerekir. Tavsiyemiz, onu yalnızca arama motorlarının asla görmemesi gereken veya izin verilerek taramayı önemli ölçüde etkileyebilecek dosyalar veya sayfalar için kullanmaktır. Yaygın örnekler: birçok farklı url oluşturan oturum açma alanları, test alanları veya çok yönlü gezinmenin bulunabileceği yerler. Ayrıca robots.txt dosyanızı herhangi bir sorun veya değişiklik olasılığına karşı düzenli olarak kontrol ettiğinizden emin olun.

Robots.txt dosyalarıyla ilgili görünen sorunların büyük çoğunluğu üç bölüme ayrılıyor:

- Joker (wildcard *) karakterlerin yanlış kullanımı. Sitenin bloke edilmesi amaçlanan bölümlerinin engellendiğini görmek oldukça yaygındır. Bazen dikkatli olmazsanız direktifler de birbiriyle çelişebilir.

- Geliştiricilerden biri aniden bir değişiklik yapabilir (genellikle yeni kodları ya da sayfaları test ederken) robots.txt dosyasını sizin bilginiz dışında istemeden değiştirmiş olabilir.

- Bir robots.txt dosyasına ait olmayan yönergelerin dahil edilmesi. Robots.txt web standardıdır ve sınırları bellidir. Çoğu zaman geliştiricilerin işe yaramayacak direktifler oluşturduğuna tanık oluyoruz (en azından tarayıcıların büyük çoğunluğu için). Bazen bu zararsız bir işlemdir, bazen tahmin edemeyeceğiniz sonuçlar doğurabilir.

BulutPress® cms yazılımı robots.txt dosyasını kendisi ürettiğinden ve son kullanıcının insiyatifine bırakmadığından, yukarıda bahsettiğimiz hatalarla karşılaşma ihtimaliniz sıfırdır.

Bir e-ticaret web sitesi işlettiğinizi ve ziyaretçilerin ürünlerinizi hızlıca aramak için bir filtre kullanmak istediklerini düşünelim. Bu filtre, temelde diğer sayfalarla aynı içeriği gösteren sayfaları oluşturur. Bu yöntem, kullanıcılar için harika çalışabilir, ancak yinelenen içerik oluşturduğu için arama motorlarını açısından oldukça kötü bir uygulamadır. Arama motorlarının bu filtrelenmiş sayfaları dizine eklemesini ve filtrelenmiş içerikle bu URL'lerde tarama bütçesini boşa harcamasını istemezsiniz. Bu nedenle, arama motorlarının bu filtrelenmiş ürün sayfalarına erişmemesi için engelleme (disallow) kuralları oluşturmalısınız. BulutPress®'de filtreleme sayfaları robots.txt üzerinden otomatik olarak engellenmektedir.

Yinelenen içeriğin önlenmesi, kurallı URL veya meta robots etiketi kullanılarak da yapılabilir, ancak bunlar, arama motorlarının yalnızca önemli olan sayfaları taramasına izin vermeyi ele almaz. Kurallı bir URL veya meta robots etiketi kullanmak, arama motorlarının bu sayfaları taramasını engellemez. Yalnızca arama motorlarının bu sayfaları arama sonuçlarında göstermesini engeller. Arama motorlarının bir web sitesini taramak için tarama bütçesi sınırlı olduğundan, bu kısıtlı kaynağı arama motorlarında görünmesini istediğiniz sayfalara harcamanız gerekir.

Bu çok basit bir araçtır, ancak bir robots.txt dosyası, özellikle daha büyük web siteleri için doğru yapılandırılmazsa birçok soruna neden olabilir. Yeni bir tasarım veya CMS kullanıma sunulduktan sonra bir sitenin tamamını engellemek veya bir sitenin özel olması gereken bölümlerini engellememek gibi hatalar yapmak çok kolaydır. Daha büyük web siteleri için, Google'ın verimli bir şekilde taranmasını sağlamak çok önemlidir ve iyi yapılandırılmış bir robots.txt dosyası bu süreçte önemli bir araçtır.

BulutPress® ile web sitesi kurmaya karar verdiğinizde, ücret ödemeden marketten bir site seçer ve onu geçici adres olan denemehosting.com uzantılı bir alt domain (subdomain) üzerinden yayınlamış olursunuz. Buna BulutPress® dilinde Geçici Site denir. İçeriklerinizin kopya metine düşmemesi ve hem geçici adreste hem de gerçek domain adresinizde yeniden indekslenmemesi için, geçici durumda olan tüm sitelerin robots.txt dosyası otomatik olarak tüm botlara engellenmiş yönergeler sunar. BulutPress® içerik yönetim sistemi, robots.txt dosyasını web sitenizin durumuna ve o anda kullandığı modüllerin ihtiyaçlarına göre otomatik olarak yapılandırmaktadır.

Sitenizin hangi bölümlerinin Google'dan en iyi şekilde uzak tutulacağını anlamak için zaman ayırmanız gerekir; böylece, gerçekten önemsediğiniz sayfaları taramak için kaynaklarının mümkün olduğu kadar büyük bir kısmını doğru yere yönlendirmiş olursunuz.

Bir robots.txt dosyası nasıl görünür?

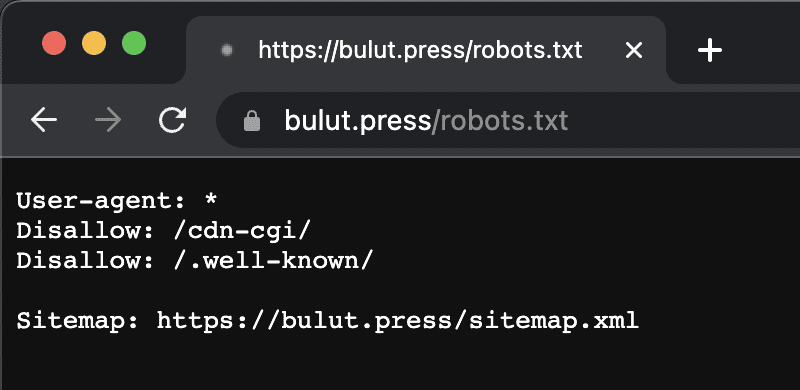

Bir BulutPress® web sitesi için basit bir robots.txt dosyasının nasıl görünebileceğine dair bir örnek:

Bir robots.txt dosyasının anatomisini yukarıdaki örneğe göre açıklayalım:

User-agent: kullanıcı aracısı, takip eden direktiflerin hangi arama motorları için olduğunu belirtir.

*: bu, yönergelerin tüm arama motorlarına yönelik olduğunu gösterir.

Disallow: Engelle, izin verme direktifi kullanıcı aracısının hangi içeriğe erişemeyeceğini belirten bir yönergedir.

/cdn-cgi/: bu, kullanıcı aracısı için erişilemeyen yoldur.

Özetle: bu robots.txt dosyası, tüm arama motorlarına /cdn-cgi/ dizininin dışında kalmalarını söyler.

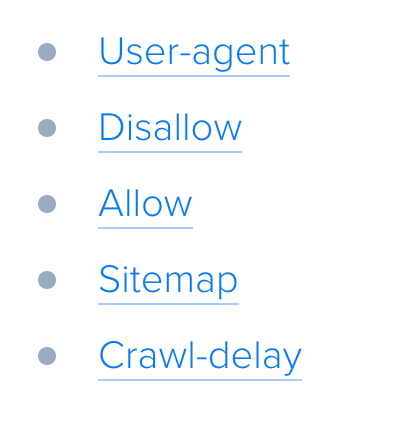

Robots.txt dosyalarının farklı bileşenlerini daha ayrıntılı olarak analiz edelim:

User-Agent: Robots.txt Dosyasında Kullanıcı Aracısı

Her arama motoru kendisini bir kullanıcı aracısı ile tanımlamalıdır. Google'ın robotları örneğin Googlebot, Yahoo'nun robotları Slurp ve Bing'in robotu BingBot vb. Kullanıcı aracısı kaydı, bir dizi direktifin başlangıcını tanımlar. İlk kullanıcı aracısı ile sonraki kullanıcı aracısı kaydı arasındaki tüm yönergeler, ilk kullanıcı aracısı için yönergeler olarak değerlendirilir. Yönergeler belirli kullanıcı aracılarına uygulanabilir, ancak tüm kullanıcı aracılarına da uygulanabilir. Bu durumda bir joker (wildcard) karakter kullanılır: User-agent: *.

Disallow: Robots.txt Dosyasındaki Yönergeyi Engellemek

Arama motorlarına web sitenizin belirli dosyalarına, sayfalarına veya bölümlerine erişmemelerini söyleyebilirsiniz. Bu Disallow yönergesi kullanılarak yapılır. Disallow yönergesini, erişilmemesi gereken yol izler. Hiçbir yol tanımlanmadıysa, yönerge yok sayılır.

Örnek

User-agent: *

Disallow: /cdn-cgi/

Bu örnekte tüm arama motorlarına /cdn-cgi/ dizinine erişmemeleri söylenmiştir.

Allow: Robots.txt Dosyasında Yönergeye İzin Vermek

Allow yönergesi, bir Disallow yönergesine karşı koymak için kullanılır. İzin ver yönergesi Google ve Bing tarafından desteklenir. Allow ve disallow yönergelerini birlikte kullanarak, arama motorlarına, aksi takdirde izin verilmeyen bir dizindeki belirli bir dosyaya veya sayfaya erişebileceklerini söyleyebilirsiniz. İzin ver yönergesini, erişilebilen yol izler. Hiçbir yol tanımlanmadıysa, yönerge yok sayılır.

Örnek:

user-agent: *

Allow: /media/gizlilik-ilkeleri.pdf

Disallow: /media/

Yukarıdaki örnekte, /media/gizlilik-ilkeleri.pdf dosyası dışında tüm arama motorlarının /media/ dizinine erişmesine izin verilmemektedir.

Önemli: Allow ve Disallow yönergelerini birlikte kullanırken, çakışan yönergelere yol açabileceğinden joker karakterler kullanmadığınızdan emin olun.

Çakışan yönergelere örnek:

User-agent: *

Allow: /dizin

Disallow: *.html

Bu örneğe göre, arama motorları http://www.example.com/dizin.html URL'si ile ne yapacaklarını bilemezler. Erişimlerine izin verilip verilmediği onlar için net değildir. Yönergeler Google için net olmadığında, en az kısıtlayıcı yönergeyle gideceklerdir, bu durumda aslında http://www.example.com/dizin.html adresine erişecekleri anlamına gelir.

Bir sitenin robots.txt dosyasındaki izin vermeme kuralları inanılmaz derecede güçlüdür, bu nedenle dikkatle ele alınmalıdır. Bazı siteler için, arama motorlarının belirli URL modellerini taramasını engellemek, doğru sayfaların taranmasını ve dizine eklenmesini sağlamak için çok önemlidir - ancak izin vermeme kurallarının uygunsuz kullanımı bir sitenin SEO'suna ciddi şekilde zarar verebilir.

Her Yönerge Ayrı Satırda Yer Almalıdır: Her yönerge ayrı bir satırda olmalıdır, aksi takdirde robots.txt dosyasını ayrıştırırken arama motorlarının kafası karışabilir.

Yanlış robots.txt dosyası örneği: user-agent: * disallow: /dizin-1/ disallow: /dizin-2/ disallow: /dizin-3/

Sitemap: Robots.txt Dosyasına Site Haritası Eklemek

Robots.txt dosyası, arama motorlarına hangi sayfaların taranmayacağını söylemek için icat edilmiş olsa da, robots.txt dosyası, arama motorlarını XML site haritasına yönlendirmek için de kullanılabilir. Bu, Google, Bing, Yahoo ve Ask tarafından desteklenmektedir.

BulutPress® içerik yönetim sistemi, web sitenizin XML site haritasını otomatik olarak oluşturur ve sitemap.xml adresinde yayınladığı sayfayı, yine otomatik olarak oluşturduğu robots.txt dosyanıza ekler.

XML site haritasına mutlak bir URL olarak başvurulmalıdır. URL'nin robots.txt dosyasıyla aynı ana bilgisayarda olması gerekmez.

XML site haritanızı Google Arama Konsolu veya Bing Web Yöneticisi Araçları'nda zaten göndermiş olsanız bile, robots.txt dosyasında XML site haritasına başvurmak, her zaman yapmanızı önerdiğimiz en iyi uygulamalardan biridir. Bu sayede gözden kaçırdığınız belki onlarca arama motorunu da oyuna dahil etmiş olursunuz.

Bir robots.txt dosyasında birden çok XML site haritasına başvurmanın mümkün olduğunu lütfen unutmayın.

Örnekler

Bir robots.txt dosyasında tanımlanan birden çok XML site haritası:

user-agent: *

disallow: /cdn-cgi/

sitemap: https://www.example.com/sitemap1.xml

sitemap: https://www.example.com/sitemap2.xml

Yukarıdaki örnek, tüm arama motorlarına /cdn-cgi/ dizinine erişmemelerini ve https://www.example.com/sitemap1.xml ve https://www.example.com/sitemap2.xml. adreslerinde bulunabilecek iki XML site haritası olduğunu söyler.

Comments: Robots.txt Dosyasında Yorumlar Yönergesi

Bazı projelerde robots.txt dosyaları çok büyük olabilir ve bazı dizinlerin ya da sayfaların neden engelendiğini geliştirici not almak ve diğer geliştiricilerin görmesini isteyebilir. Bu durumda satırın başına # işareti ekleyerek o satırın arama motorları tarafından görmezden gelinmesini sağlayabilir.

Crawl Delay: Robots.txt Dosyasında Tarama Gecikmesi

Crawl-delay yönergesi, çok fazla istek içeren sunucuların aşırı yüklenmesini önlemek için kullanılan resmi olmayan bir yönergedir. Arama motorları bir sunucuyu aşırı yükleyebiliyorsa, robots.txt dosyanıza Tarama gecikmesi eklemek yalnızca geçici bir düzeltmedir. İşin aslı, web siteniz kötü bir barındırma ortamında çalışıyor ve/veya web siteniz yanlış yapılandırılmış olabilir ve bunu en kısa sürede düzeltmeniz gerekir.

BulutPress® ile yayınlanan web siteleri oldukça gelişmiş bir bulut sunucu mimarisi üzerinde çalıştığından, Crawl-delay gibi, arama motorlarını geciktirmeyi amaçlayan yönergeleri asla kullanmak zorunda kalmaz. Çünkü web sitenizin trafik yoğunluğuna göre yük dengeleyici mekanizma ile ihtiyaca göre anlık olarak yeni uygulama sunucuları yaratılır ve sunucular her zaman en yüksek kusursuz kullanıcı deneyimi sunmaya devam ederler. Trafik azalıp yoğun ihtiyaç ortadan kalktığında ise gereksiz sunucular otomatik olarak kapatılır ve maliyetler azalmış olur. Bu sayede size en iyi sunucu hizmetini en uygun fiyatla sunmaya devam edebilmekteyiz.

Arama motorlarının tarama gecikmesini işleme şekli farklıdır. Aşağıda, büyük arama motorlarının bunu nasıl ele aldığını açıklıyoruz.

Crawl Delay: Tarama Gecikmesi ve Google

Google'ın tarayıcısı Googlebot, Tarama gecikmesi yönergesini desteklemez, bu nedenle bir Google tarama gecikmesi tanımlamakla uğraşmayın. Ancak Google, Google Search Console GSC'da bir tarama hızı (veya tercihe bağlı "istek oranı" - request rate) tanımlamayı destekler.

GSC'de tarama hızını ayarlama:

- Google Arama Konsolunda oturum açın(yeni bir sekmede açılır).

- Tarama hızını tanımlamak istediğiniz web sitesini seçin.

- İnce ayar yapabileceğiniz tek bir ayar vardır: Tercih edilen tarama hızını ayarlayabileceğiniz bir kaydırıcı ile tarama hızı. Varsayılan olarak tarama hızı "Google'ın sitem için optimizasyon yapmasına izin ver (önerilir)" olarak ayarlanmıştır.

Crawl Delay: Tarama Gecikmesi ve Bing, Yahoo ve Yandex

Bing, Yahoo ve Yandex'in tümü, bir web sitesinin taranmasını kısmak için tarama gecikmesi yönergesini destekler. Tarama gecikmesini yorumlamaları biraz farklıdır, bu nedenle belgelerini kontrol ettiğinizden emin olun.

Crawl Delay: Tarama Gecikmesi ve Baidu

Baidu, tarama gecikme yönergesini desteklemez, ancak Google Arama Konsolu'na benzer şekilde, tarama sıklığını kontrol edebileceğiniz bir Baidu Web Yöneticisi Araçları hesabına kaydolmak mümkündür.

Bir Robots.txt Dosyası Ne Zaman Kullanılır?

Her zaman bir robots.txt dosyası kullanmanızı öneririz. Buna sahip olmanın kesinlikle bir zararı yoktur ve arama motorlarına web sitenizi en iyi şekilde nasıl tarayabilecekleri konusunda yönergeler vermek için harika bir yerdir.

robots.txt, sitenizdeki belirli alanların veya belgelerin taranmasını ve dizine eklenmesini önlemek için yararlı olabilir. Arama motorları tarafından neyin dizine eklenmesi gerektiğini dikkatlice planlayın ve robots.txt aracılığıyla erişilemez hale getirilen içeriğin, web sitesinin diğer alanlarından bağlantı verilmişse arama motoru tarayıcıları tarafından yine de bulunabileceğini unutmayın.

Robots.txt En İyi Uygulamaları Nelerdir?

robots.txt en iyi uygulamaları aşağıdaki gibi kategorilere ayrılır:

1. Konum ve Dosya Adı: Robots.txt dosyası her zaman bir web sitesinin kök dizinine (ana bilgisayarın en üst düzey dizinine) yerleştirilmeli ve robots.txt dosya adını taşımalıdır, örneğin: https://www.example.com/robots.txt . robots.txt dosyasının URL'sinin, diğer tüm URL'ler gibi, büyük/küçük harfe duyarlı olduğunu unutmayın.

Robots.txt dosyası varsayılan konumda bulunamazsa, arama motorları hiçbir yönerge olmadığını varsayar ve web sitenizde dilediği gibi gezinir.

2. Öncelik Sırası: Arama motorlarının robots.txt dosyalarını farklı şekilde ele aldığını unutmamak önemlidir. Varsayılan olarak, ilk eşleşen yönerge her zaman kazanır.

Ancak, Google ve Bing arama motorlarında özgüllük kazanır.

Örneğin: Bir Allow yönergesi, karakter uzunluğu daha uzunsa bir Disallow yönergesini ezer.

3. Robot Başına Sadece Bir Grup Direktif Verin: Her arama motoru için yalnızca bir grup yönerge tanımlayabilirsiniz. Bir arama motoru için birden fazla yönerge grubuna sahip olmak onların kafasını karıştırır.

4. Mümkün Olduğunca Spesifik Olun: Disallow yönergesi, kısmi eşleşmelerde de tetiklenir. Dosyalara istemeden erişime izin vermemek için Disallow yönergesini tanımlarken mümkün olduğunca spesifik olun.

# Örnek:

user-agent: *

disallow: /dizin

Yukarıdaki örnek, arama motorlarının şunlara erişmesine izin vermemektedir:

- /dizin

- /dizin/

- /dizin-adı-1

- /dizin-adı.html

- /dizin-adı.php

- /dizin-adı.pdf

5. Tüm Robotlar İçin Yönergeler ve Belirli Bir Robot İçin Yönergeleri Dahil Etmek: Bir robot için sadece bir grup direktif geçerlidir. Tüm robotlara yönelik direktiflerin belirli bir robota yönelik direktiflerle takip edilmesi durumunda, sadece bu spesifik direktifler dikkate alınacaktır. Belirli robotun tüm robotlar için yönergeleri de takip etmesi için, bu yönergeleri belirli robot için tekrarlamanız gerekir.

Robots.txt dosyanızın herkese açık olduğunu lütfen unutmayın. İzin vermediğiniz klasörlerin listesi robots.txt dosyasında açıkça yayınlanacağı için kötü niyetli kişilerin dikkatini çekebilir. Bu nedenle robots.txt tehlikeli olabilir. Arama motorlarına sadece bakmalarını istemediğiniz yerleri söylemiyorsunuz, insanlara bazı sayfalarınız nereye sakladığınızı da söylüyorsunuz.

6. Her (Alt) Etki Alanı İçin Robots.txt Dosyası Oluşturun: Robots.txt yönergeleri yalnızca dosyanın barındırıldığı (alt) etki alanı için geçerlidir. (Alt) alan adınızda yalnızca bir robots.txt dosyasının bulunması en iyi uygulamadır.

Kullanılabilir birden fazla robots.txt dosyanız varsa, bunların bir HTTP durumu 404 döndürdüğünden emin olun veya 301'e bunları standart robots.txt dosyasına yeniden yönlendirin.

BulutPress® web sitenizin ilave dilleri için dilerseniz her bir dile ayrı sub-domain (alt alan adı) kullanabilir, dilerseniz ayrı alan adı kullanabilirsiniz. Her durumda, her alt etki alanı için otomatik olarak ayrı robots.txt dosyaları otomatik olarak oluşturulur.

7. Çakışan Yönergeler - Robots.txt ve Google Arama Konsolu: Robots.txt dosyanızın Google Search Console'da tanımlanan ayarlarla çakışması durumunda, Google genellikle robots.txt dosyasında tanımlanan yönergeler üzerinden Google Search Console'da tanımlanan ayarları kullanmayı tercih eder.

8. Robots.txt Dosyanızı Gözlemleyin: Değişiklikler için robots.txt dosyanızı izlemeniz önemlidir. Eğer BulutPress® kullanmıyorsanız yanlış yönergelerin ve robots.txt dosyasındaki ani değişikliklerin büyük SEO sorunlarına neden olduğu birçok sorun görüyoruz.

Bu, özellikle yeni özellikler veya bir test ortamında hazırlanmış yeni bir web sitesi oluşturulurken geçerlidir, çünkü bunlar genellikle aşağıdaki robots.txt dosyasını içerir. Bu satırlar yalnızca GEÇİCİ durumda ve *.denemehosting.com gibi üretim amaçlı kullanılan domain üzerinde yayınlanan sitelerde kullanılmalıdır. Bu sayede içerikleriniz yanlış domainde arama motorları tarafından yanlışlıkla indekslenmemiş olur. Daha önce bahsettiğimiz gibi, BulutPress® bunu sizin yerinize yapmaktadır. Ancak başka bir servis kullanıyorsanız, üretim sürecinde aşağıdaki satırların robots.txt dosyanıza eklendiğinden emin olmalısınız.

user-agent: *

disallow: /

9. Robots.txt Dosyanızda Noindex Kullanmayın: Google, yıllardır resmi olmayan noindex yönergesinin kullanılmamasını açıkça söylüyordu. Ancak 1 Eylül 2019 itibarıyla Google, onu desteklemeyi tamamen durdurdu.

Sayfaların dizine eklenmemesi gerektiğini arama motorlarına bildirmenin en iyi yolu meta robots etiketini sayfa içinde kullanmak veya sitenin header yanıtında X-Robots-Tag'i kullanmaktır.

10. Robots.txt Dosyasında UTF-8 BOM Kullanmayın: BOM, bir metin dosyasının Unicode kodlamasını belirtmek için kullanılan bir dosyanın başındaki görünmez bir karakter olan bayt sıra işareti anlamına gelir.

Google, robots.txt dosyasının başındaki isteğe bağlı Unicode bayt sırası işaretini yok saydıklarını belirtirken, yorumlanmasıyla ilgili sorunlara neden olduğunu gördüğümüz için "UTF-8 BOM" kullanmamanızı öneririz.

Google bu sorunla başa çıkabileceklerini söylese de, UTF-8 BOM'u kullanmamanız için iki neden var:

Arama motorlarına tarama ile ilgili tercihlerinizle ilgili herhangi bir belirsizlik olmasını istemezsiniz.

Google'ın iddia ettiği kadar bağışlayıcı olmayan başka arama motorları da var.

BulutPress® robots.txt dosyasında UTF-8 BOM işaretlemesini kullanmamaktadır.

Robots.txt Dosyasının Sınırlamaları Nelerdir?

Robots.txt dosyası çeşitli yönergeler içerir: Robots.txt, arama motorları tarafından büyük saygı görse de, yine de bir yönergedir ve bir zorunluluk değildir.

Hala arama sonuçlarında görünen sayfalar: Robots.txt nedeniyle arama motorları tarafından erişilemeyen ancak bunlara bağlantıları olan sayfalar, taranan bir sayfadan bağlantı verilmişse arama sonuçlarında görünmeye devam edebilir.

Google Search Console'un URL kaldırma aracını kullanarak bu URL'leri Google'dan kaldırmak mümkündür. Lütfen bu URL'lerin yalnızca geçici olarak "gizli" olacağını unutmayın. Google'ın sonuç sayfalarının dışında kalmaları için, her 180 günde bir URL'leri gizlemek üzere bir istek göndermeniz gerekir.

İstenmeyen ve muhtemelen zararlı geri bağlantılarını engellemek için robots.txt dosyasını kullanın. İçeriğin arama motorları tarafından dizine eklenmesini önlemek amacıyla robots.txt dosyasını kullanmayın, çünkü bu kaçınılmaz olarak başarısız olacaktır. Bunun yerine, gerektiğinde robot yönergesi olan html web sayfanızın içindeki meta noindex'i uygulayın.

Robots.txt dosyası 24 saate kadar önbelleğe alınır: Google, bir robots.txt dosyasının genellikle 24 saate kadar önbelleğe alındığını belirtmektedir. Robots.txt dosyanızda değişiklik yaparken bunu dikkate almanız önemlidir.

Diğer arama motorlarının robots.txt dosyasının önbelleğe alınmasıyla nasıl başa çıktığı açık değildir, ancak genel olarak arama motorlarının değişiklikleri algılayabilmesi için gerekenden daha uzun sürmesini önlemek için robots.txt dosyanızı önbelleğe almaktan kaçınmak en iyisidir.

Robots.txt dosya boyutu: Google, robots.txt dosyaları için şu anda 512 kilobayt dosya boyutu sınırını desteklemektedir. Bu maksimum dosya boyutundan sonraki herhangi bir içerik yok sayılabilir. Diğer arama motorlarının robots.txt dosyaları için maksimum dosya boyutuna sahip olup olmadığı açık değildir.